Il 21 dicembre 2020 si è raggiunta la minima distanza angolare in cielo tra Giove e Saturno dal 1623, in una delle congiunzioni più spettacolari che abbia visto fin'ora. Vedere entrambi i pianeti così vicini nello stesso oculare è stata una grande emozione, così come impressionarli sul mio piccolo sensore CMOS ottenendo questa immagine:

Andiamo per gradi, dato che ho molte cose in testa che voglio raccontarvi. Partiamo dal titolo: che c'entra la stella di Betlemme? Si avvicina il Natale e con esso tornano in mente tutti i racconti della tradizione cristiana, compreso quello di questa stella che con la sua luce ha guidato i Magi verso il luogo in cui nacque Gesù. Cosa poteva mai essere questa luce prodigiosa visibile per lungo tempo nel cielo? Nel corso dei secoli si susseguirono diverse interpretazioni. Una convinzione ancora molto radicata nel pensiero comune è che si trattasse di una cometa apparsa improvvisamente in cielo in quel periodo. Probabilmente non fu così, ma almeno sappiamo il perché la "cometa di Natale" sia così gettonata: tutta colpa di Giotto. Nella scena di natività che dipinse nella cappella degli Scrovegni si vede chiaramente un astro chiomato sorvolare la stalla che ospita Gesù. Il motivo per cui Giotto inserì una cometa nella natività è probabilmente dovuto al fatto che in quegli anni passò vicino alla Terra la 1/P Halley, e lo lasciò sicuramente sbalordito, tanto da immortalarla nella sua opera.

La rappresentazione della cometa come stella di betlemme non ha molti riscontri storici: gli astronomi cinesi o arabi hanno sempre tenuto traccia di eventi come comete, nove o supernove, ma non hanno visto niente negli anni vicini all'anno 0. Il primo a formulare un'ipotesi diversa fu Keplero in persona: osservò con stupore la congiunzione tra Giove e Saturno del 1623 e calcolando a ritroso la posizione dei due pianeti scoprì che una simile congiunzione era avvenuta nel 7 avanti cristo. Per la verità, un raro gioco di meccanica celeste fece sì che tale congiunzione avvenisse ben tre volte, dato che si sovrapposero i moti retrogradi di entrambi i giganti gassosi, mantenendoli vicini in cielo per molti mesi. Ciò non è abbastanza per risolvere il mistero, ma ci fornisce sicuramente un'idea diversa dalla "stella cometa" tanto menzionata.

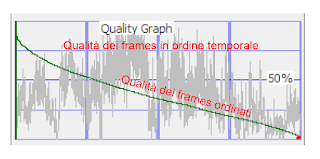

Torniamo adesso all'anno 2020 e osserviamo meglio l'immagine che avete visto poco sopra. Per scattarla ho realizzato quattro video nei filtri IR742, R, G e B. Il primo video ha fornito le informazioni di luminanza, gli ultimi tre i colori. Ho ripreso tutti i video utilizzando l'intero sensore della telecamera, perché l'idea di avere entrambi i pianeti nello stesso campo mi piaceva molto. Tuttavia non avevo considerato un piccolo dettaglio: si muovono. Per questa ragione succedevano due cose: i software di stacking impazzivano non sapendo su quale allineare le immagini e la sovrapposizione dei canali trasformava i pianeti in graziosi arlecchini colorati. Per ottenere i colori quindi ho elaborato due volte tutti e tre i filmati allineando una volta su Giove e una su Saturno, allineando poi manualmente il tutto. Un discreto lavoraccio.

Infine arriviamo ad una parte un po' più tecnica, che conterrà anche della terrificante matematica al suo interno. Non mi offendo se saltate direttamente all'ultimo paragrafo, ovviamente! Prendiamo questa immagine che ho scattato la sera del 20 (giusto per variare, tra l'altro il cielo era pure meno velato rispetto al 21):

Appare evidente come Saturno sia nettamente più debole rispetto a Giove, cosa facilmente verificabile anche ad occhio nudo tra l'altro. Appena ho visto questa immagine mi è balenata un'idea in testa: si potrà sfruttare questa informazione per calcolare la distanza tra Giove e Saturno? Risposta breve: no. Si può però calcolare il rapporto tra le loro distanze dalla Terra, che è comunque un'informazione interessante. In tutte le rappresentazioni dell'universo tolemaico, per esempio, Saturno non si trova affatto al doppio della distanza da noi!

Per fare questa misura dobbiamo però fare un'assunzione: supporremo che Giove e Saturno riflettano la luce solare allo stesso modo e nella stessa quantità, ovvero hanno lo stesso albedo. Un'assunzione piuttosto forte, ma forse persino un terrapiattaro potrebbe ipotizzare che due oggetti che appaiono simili in cielo siano fisicamente molto simili tra loro.

Tramite una paginetta di calcoli (che i più esigenti possono trovare qui sotto) è possibile dimostrare che il rapporto tra le brillanze superficiali dei pianeti è uguale al rapporto dei quadrati delle distanze tra Sole e pianeta.

|

| Ma quale blogger vi ricopia i conti su LaTeX? (Grazie a Francesco per aver riguardato i conti!) |

La brillanza superficiale è un numeretto che ci dice, in sostanza, quanta luce emette ogni pezzettino di pianeta. Tale numeretto è molto interessante perché non dipende dalla distanza a cui si trova un pianeta e si può calcolare in un colpo solo avendo solamente una foto come quella di sopra. Possiamo infatti misurare il flusso sommando tutti i pixel che compongono il disco del pianeta (sottraendo il valore del fondo cielo, misurato con un "anello" attorno all'apertura fotometrica) e stimare il diametro angolare misurando quanti pixel sono larghi. A questo punto la brillanza è semplicemente il rapporto tra il flusso del pianeta e il suo angolo solido (praticamente un'area angolare). Nell'immagine qui sotto potete trovare il flusso misurato, il diametro angolare e le aperture fotometriche usate.

|

I "solchi" a destra e a sinistra del disco sono dovuti al tipico bordino nero lasciato dal processing con i wavelet. |

|

| Così parlò Python |

Non male, Il risultato ottenuto si discosta da quello reale dell'2.4%! Noterete però che l'errore relativo sul rapporto misurato è inferiore a questo 2.4%, vale infatti circa 0.7%. In altre parole, gli errori su flusso e raggio del pianeta, che sono le grandezze da noi misurate, non sono sufficientemente grandi da giustificare un tale discostamento rispetto al valore vero. Questo perché abbiamo fatto tante semplificazioni nei nostri conti: abbiamo considerato i due pianeti con lo stesso albedo (e non è vero), oltre al fatto che nella misura di flusso di Saturno abbiamo incluso anche un pezzo di anello, che ha sicuramente inquinato la misura, avendo un albedo molto diverso dal pianeta.

A questo punto avrei potuto prendere una tabella degli albedo di Giove e Saturno online e ripetere il procedimento senza considerarli uguali... più facile a dirsi che a farsi. L'albedo dipende fortemente da molti fattori: la stagione in corso sul pianeta, la situazione atmosferica, la fase, oltre a fattori strumentali come il range di frequenze in cui li sto riprendendo e l'efficienza del sensore. Per uno scarto così piccolo, forse, non vale la pena rovinarsi il capodanno. Teniamoci per buona questa misura precisa, ma non troppo, di quanto è profondo il nostro Sistema Solare.

Mi rendo conto di essere stato un po' tecnico in quest'ultima parte, ma volevo dimostrare, almeno agli astrofili più smanettoni, come tramite una semplice foto con un telescopio amatoriale fosse possibile ottenere interessanti informazioni astronomiche. Un po' di sana astrofisica da balcone, se preferite chiamarla così. Con questo articolo lasciamo alle spalle un 2020 terribile sotto molti aspetti, ma che dal punto di vista astronomico è stato molto ricco. Vediamo cosa succederà nel 2021: io ovviamente non lo so. So solo che il cielo e l'astronomia non si fermano mai.